기계 학습 어플리케이션을 활용한 파노라마 영상에서의 정중 과잉치 식별

Identification of Mesiodens Using Machine Learning Application in Panoramic Images

Article information

Abstract

이번 연구는 손쉽게 접근 가능한 웹사이트 기반 기계 학습 어플리케이션을 활용하여 파노라마 방사선 영상에서 과잉치 식별 모델을 학습시키고, 학습된 모델의 과잉치를 식별하는 성능을 평가하고자 하였으며, 인간 집단과의 성능을 비교하기 위한 연구를 진행하였다.

총 1604장의 5 - 7세 환자의 파노라마 이미지가 이번 연구에서 사용되었다. 연구에 사용된 모델은 Google에서 개발한 기계학습 모델인 Teachable Machine을 사용하였다. 과잉치 식별 모델을 훈련시키고 성능을 평가하기 위해 data set 1을 설정하였다. Data set 2는 학습모델과 인간 집단 간의 정확도 비교를 위해 설정하였다. 학습모델 및 인간 집단의 과잉치 식별 능력을 평가하기 위해 정확도(accuracy), 민감도(sensitivity), 특이도(specificity) 값을 사용하였다.

Data set 1의 검증 결과, 평균 0.82의 분류 정확도를 얻었다. Data set 2의 테스트 결과, 모델의 정확도는 0.78이었다. 전공의군과 학생군의 평균 정확도는 각각 0.82, 0.69였다.

이번 연구는 유치열기 및 초기 혼합치열기 어린이의 파노라마 방사선 영상과 웹 기반 기계 학습 어플리케이션 이용하여 과잉치 식별 모델을 개발하였고 학습된 모델과 인간 의사 집단(전공의 및 학생) 간의 과잉치 식별 정도를 비교 연구하였다. 훈련모델의 분류 정확도는 전공의군과 비교 시 낮았지만 훈련받지 않은 치과 대학 학생군보다 분류 정확도가 높아 비전문가 학생 또는 일반의사에게 과잉치 진단 정확도를 높이는 데 활용될 가능성이 있음을 확인하였다.

Trans Abstract

The aim of this study was to evaluate the use of easily accessible machine learning application to identify mesiodens, and to compare the ability to identify mesiodens between trained model and human.

A total of 1604 panoramic images (805 images with mesiodens, 799 images without mesiodens) of patients aged 5 – 7 years were used for this study. The model used for machine learning was Google’s teachable machine. Data set 1 was used to train model and to verify the model. Data set 2 was used to compare the ability between the learning model and human group.

As a result of data set 1, the average accuracy of the model was 0.82. After testing data set 2, the accuracy of the model was 0.78. From the resident group and the student group, the accuracy was 0.82, 0.69.

This study developed a model for identifying mesiodens using panoramic radiographs of children in primary and early mixed dentition. The classification accuracy of the model was lower than that of the resident group. However, the classification accuracy (0.78) was higher than that of dental students (0.69), so it could be used to assist the diagnosis of mesiodens for non-expert students or general dentists.

Ⅰ. 서 론

현재 치의학 분야에서의 인공지능을 이용한 연구가 활발하다. 대부분의 연구는 치과 영상을 이용하며 진단을 위한 보조기구로 활용하는 것이다[1,2]. 인공지능 활용 연구를 위해서는 많은 수의 데이터와 학습모델이 필요하다[1]. 영상을 이용한 여러 연구에서 전이학습을 이용한 Alexanet, VGG16, ResNet, DetectNet, Unet같은 모델을 학습모델로 사용하였다[3]. 하지만, 의료 영상은 기존의 학습에 사용된 일반 영상과 다르기 때문에 모델은 풀고자 하는 문제에 최적화되어 있지 않다. 또한 의료 영상 데이터의 수는 일반적인 영상과 달리 많은 양을 확보하기 쉽지 않다. 이는 개인정보와 관련되어 있기 때문이다. 따라서 의료분야에서의 인공지능 연구는 모델의 개발과 데이터의 확보에 어려움이 있다[4].

파노라마 방사선영상은 초기 진단 도구로써 이용되며 한 번의 방사선영상을 촬영을 통해 비정상적인 구조물을 쉽게 찾아낼 수 있다[5]. 특히 소아치과 영역에서 유치열기, 혼합치열기 치열의 발육과 맹출 과정에서 다양한 형태학적, 수적 문제들을 발견할 수 있다[6]. 뿐만 아니라 구내 방사선 촬영에 비해 간편하고 방사선 노출량이 적다는 장점이 있어 소아치과에서 널리 사용되고 있다[6,7]. 과잉치는 정상치아 수보다 많은 치아로 상악 전치부에서 호발한다[8]. 과잉치가 적절한 시기에 발치되지 않는다면 인접 영구치의 맹출 지연, 전위, 정중 이개, 총생, 치근의 흡수 등 다양한 합병증을 유발할 수 있다. 따라서 합병증을 최소화하고 적절한 치료계획을 세우기 위해서는 과잉치의 조기 발견이 중요하다[9-11]. 하지만 파노라마 영상에서 상악 전치부는 좁은 초점층으로 뚜렷한 상을 얻기가 어려우며 여러 구조물이 겹치는 문제로 인해 정확한 판독이 어렵다[12]. 특히, 임상가의 숙련도에 따라 파노라마 상에서 정중과잉치 식별이 어렵거나 정중과잉치의 존재를 간과할 수 있다[13].

최근에는 인공지능 학습모델을 인터넷상에서 프로그래밍 언어로 코딩하지 않고도, 비교적 간단한 사용자 인터페이스(user interface)를 이용해서 모델을 만들 수 있는 방법들이 공개되고 있다. 인공지능에 익숙하지 않은 의료인이 쉽게 데이터를 학습시키고, 모델을 개발할 수 있다면 의료영역에서의 인공지능 연구가 더 활발하게 이루어질 수 있다. 이 연구는 손쉽게 접근 가능한 인공지능 기반 웹사이트 어플리케이션을 활용하여 파노라마 영상에 있는 과잉치를 학습시키고, 정상치아와 구분하는 성능을 평가하여 진단에 활용하고자 한다. 그리고 인간의사집단과 인공지능 훈련모델의 성능을 비교 평가하였다.

Ⅱ. 연구 재료 및 방법

해당 연구는 전북대학교병원 연구심의위원회(Institutional Review Board)의 심사위원의 승인을 받았다(IRB File No. CUH 2021-04-003)

1. 연구 대상

연구대상은 정중과잉치를 포함한 실험군과 정중과잉치가 없는 대조군으로 선정하였다. 실험군은 2000년 1월부터 2020년 6월까지 전북대학교 치과병원에서 한국표준질병 사인분류 코드 K.0010(supernumerary teeth of incisor and canine region)으로 진단받고 파노라마 방사선 영상을 촬영한 5 - 7세의 환자 937명을 대상으로 하였다. 대조군은 2017년 8월부터 2019년 11월까지 전북대학교 치과병원에서 한국표준질병 사인분류 코드 K.0010(supernumerary teeth of incisor and canine)으로 진단받지 않고 파노라마 방사선 사진을 촬영한 5 - 7세 환자 1000명을 대상으로 하였다. 이후 다음과 같은 선정기준 및 제외기준에 따라 한 개 이상의 정중과잉치를 포함한 파노라마 영상 805장과 정중과잉치가 없는 파노라마 영상 799장이 실험군 및 대조군으로 선별되었다(Table 1). 정중과잉치의 존재는 한 명의 영상치의학 전문의와 한 명의 소아치과 전문의에 의해 확인되었다.

1) 선정기준

(1) 초기 혼합치열기 어린이

(2) 유치열기 어린이

2) 제외기준

(1) 관심영역에 indirect restoration 치료를 받은 어린이

(2) 구순-구개열 기왕력의 어린이

(3) 증후군이 있는 어린이

2. 데이터 전처리

모든 이미지는 INFINITT G3(INFINITT Healthcare Co. Ltd, Seoul, Korea) PACS 시스템을 이용하여 JPEG 포맷(2560x1500)으로 다운로드 하였다. 데이터 전처리를 효과적으로 진행하기 위해 한 명의 치과의사가 포토샵 프로그램(Adobe System Inc., San Jose, CA, USA)을 이용하여 직사각형 형태의 관심영역을 파노라마 영상에서 수동으로 잘라내 JEPG 파일로 저장하였다. 관심 영역에는 상악 영구 견치와 측절치 사이의 양측 접촉점 또는 상악 유견치와 상악 제1유구치 접촉점과 비강의 하선과 맹출한 상악 절치의 절단연이 포함되었다(Fig. 1).

3. 데이터 분류

과잉치 식별 모델을 훈련시키고 훈련된 모델의 성능을 검증하기 위해 data set 1을 설정하였다. Data set 1은 총 1574장의 전 처리 된 영상(과잉치를 포함한 790장, 784장)을 사용하였다. 훈련시킨 과잉치 식별 모델의 성능을 인간군(전공의, 본과 4학년 학생)과 비교하기 위해 data set 2를 설정하였다. Data set 2은 총 30장의 전처리 된 영상을 사용(과잉치를 포함한 15장과 과잉치가 없는 15장)하였다.

4. 딥러닝 구조(Deep learning architecture)

이 연구에서는 Google의 Teachable Machine(TM) ver. 2.0 모델을 활용하여 데이터를 학습하고 검증을 진행하였다[21]. 최적화 모델을 선정하기 위해 다양한 조건에서 실험을 진행하였고, 최적화 모델을 다음과 같은 훈련조건에서 얻었다(epoch:200, batch: 16, learning rate: 0.00001).

5. 평가방법

1) 분류 모델의 평가

Data set 1(1574장)의 85%(1456장)가 무작위로 프로그램 내에서 자동으로 배정되어 모델 훈련에 사용되었다. Data set 1을 이용하여 만든 과잉치 식별 모델의 성능을 검증하기 위해 학습에 사용되지 않은 data set 1의 15%(118장)가 무작위로 프로그램 내에서 자동으로 배정되었다. 검증의 결과는 true positive(TP), true negative(TN), false positive(FP), false negative(FN)로 분류되어 다음과 같이 정확도(accuracy), 민감도(sensitivity), 특이도(specificity)를 계산하였다.

Sampling bias가 발생하는 문제를 해결하기 위해 같은 매개변수 조건하(epoch:200, batch: 16, learning rate: 0.00001)에서 모델을 6번 생성하여 6번의 검증을 진행하였고 결과값의 평균을 내어 모델 성능을 평가하였다.

2) 분류 모델과 인간 집단의 과잉치 식별 능력 평가

Data set 2는 학습모델과 인간군 간의 과잉치 식별 능력을 비교하기 위해 data set 1에서 사용되지 않은 방사선 영상(실험군 15장, 대조군 15장)을 사용하였다. Data set 1을 사용하여 얻은 6개의 학습 모델에 대해 각각 data set 2를 입력하여 과잉치 식별 결과를 기록하였다. 인간 집단은 전북대학교 소아치과 전공의 5명과 전북대학교 치과대학 본과4학년 5명을 선정하였다. 인간 집단은 동일한 조건(컴퓨터, 문제순서, 제한시간 10분)에서 테스트를 진행하였고 과잉치 식별 결과를 기록하였다. Data set2의 식별 결과에 대해 정확도, 민감도, 특이도를 계산하였고 평균값을 산출했다.

6. 통계처리

얻어진 데이터는 SPSS(version 18.0, IBM, USA)를 이용하여 통계 분석을 시행하였다. 각 군(모델, 전공의, 학생)의 N수가 10개 미만이기 때문에 민감도, 특이도, 정확도에 대한 통계적 유의성 검증은 비모수 검정 방법인 Kruskal-Wallis test를 사용하였다.

Ⅲ. 연구 성적

1. 훈련모델의 분류성능

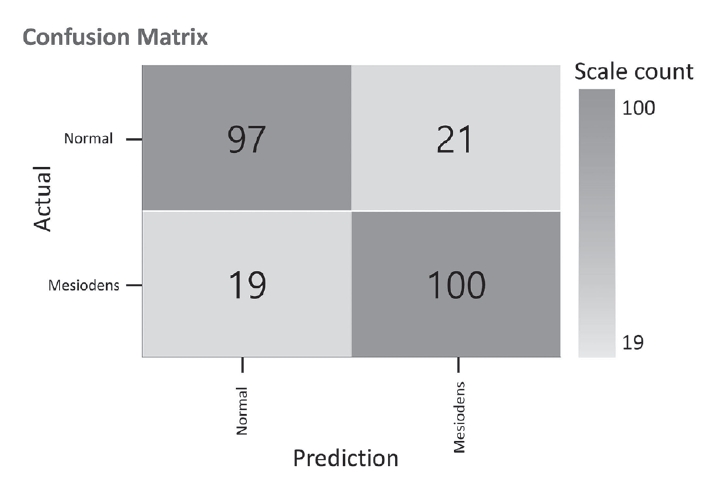

Data set 1을 이용하여 얻은 검증 결과는 true positive(TP), true negative(TN), false positive(FP), false negative(FN)로 분류되어 confusion matrix 형태로 표시되었다(Fig. 2). 각 모델의 성능은 민감도, 특이도, 정확도에 따라 평가하였으며 각 모델의 평균값은 각각 0.82, 0.82, 0.82로 나타났다(Table 2).

2. 인간의사 집단과의 비교 분류성능

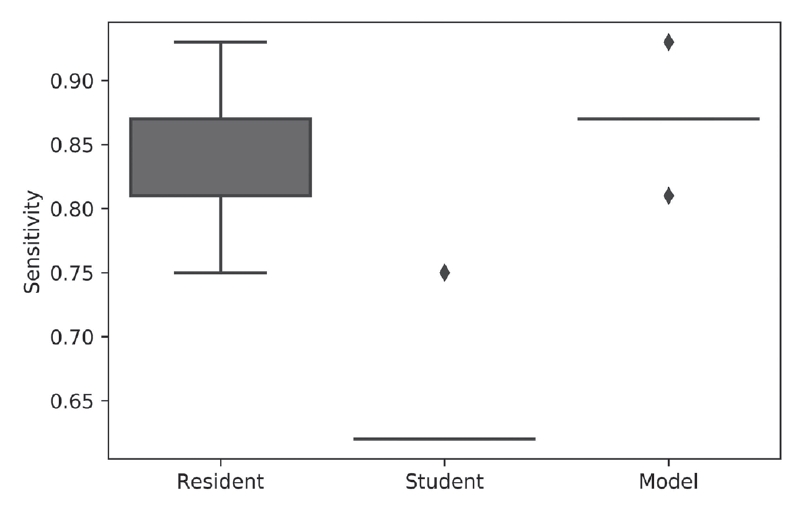

Data set 1을 사용하여 얻은 6개의 모델에 data set 2를 입력했을 때의 민감도, 특이도, 정확도의 평균값은 각각 0.87, 0.67, 0.78이었다(Table 3). Data set 2를 전공의군에서 테스트하여 얻은 민감도, 특이도, 정확도의 평균값은 0.85, 0.8, 0.82였다(Table 4). 본과 4학년 학생 그룹에서 테스트하여 얻은 민감도, 특이도, 정확도의 평균값은 0.64, 0.71, 0.69였다(Table 4). Kruskal-Wallis test를 통해 보았을 때 민감도와 정확도에서 각 군 간에 유의한 차이(p = 0.005, p = 0.02)를 확인할 수 있었지만 특이도에서는 각 군 간에 유의한 차이가 없었다(p = 0.27)(Fig. 3-5).

Boxplot of sensitivity among three groups (Resident, Student, Model). Kruskal-Wallis test was performed to analyze the statistical significance of sensitivity.

Boxplot of specificity among three groups (Resident, Student, Model). Kruskal–Wallis test was performed to analyze the statistical significance of specificity.

Ⅳ. 총괄 및 고찰

정중과잉치의 진단을 위한 도구로 파노라마 방사선 사진, ‘SLOB’(same-lingual, opposite-buccal) 방법을 이용한 치근단 방사선 사진, 상악 교합면 방사선 사진, cone-beam형 전산화 단층촬영술(cone-beam computed tomography, CBCT) 등이 사용된다[5,7]. 파노라마 영상에 비해 CBCT 영상은 과잉치의 정확한 위치, 치근 흡수 유무 파악 및 치료 계획에 필요한 더 많은 정보를 제공한다[12]. 하지만 파노라마 방사선촬영은 적은 방사선노출과 초기 진단 도구로서의 이점이 있다[6,14].

Anthonappa 등[13]은 과잉치를 식별을 위한 파노라마 영상의 유효성에 대한 연구 결과를 발표하였다. 파노라마 영상을 이용한 과잉치를 식별한 결과, 민감도와 특이도가 각각 0.5, 0.98을 나타냈다. 이를 통해 저자는 파노라마 이미지를 통한 진단이 신뢰할 수 없다고 하였다. 또한, 소아치과 전공의군(0.6)과 졸업한지 1년 미만인 치과의사군의 민감도(0.39)에서 유의할 만한 차이를 나타냈는데 이를 통해 임상가의 경험이 과잉치 식별에 영향을 주며 올바른 과잉치 식별을 위해서는 높은 수준의 훈련이 필요하다고 하였다. 이번 연구는 파노라마 영상과 웹 기반 기계 학습 어플리케이션을 활용하여 과잉치 식별 모델을 만들었다. 이번 연구에서도 선행 연구처럼 임상 경험에 따라 과잉치의 식별 능력이 다르다는 것을 확인할 수 있었다. 인간집단에서의 평가 지표의 편차가 훈련모델에 비해 높게 관찰되었고, 그에 비해 인공지능은 비교적 일정한 식별 능력을 보이는 것을 확인할 수 있었다. Data set 2의 틀린 문제 목록을 보았을 때 인공지능은 틀린 문제가 일정했으나 인간 집단에서는 틀린 문제가 다양하게 나타났다. 또한 인간 집단과 비교하였을 때도 양호한 과잉치 식별능력을 보였다.

Kuwada 등[15]은 인공지능을 활용하여 영구치열기 성인을 대상으로 파노라마 상에서 상악 전치부 과잉치를 식별하고 감지하는 연구를 최초로 보고하였다. 해당 연구는 DetectNet, AlexNet을 사용하여 상악 전방부 과잉치 식별을 시행하였고 각각 0.93 - 96, 0.8 - 0.9의 비교적 높은 정확도를 보고하였다. 하지만 해당 연구에서는 영구치열기의 성인데이터만 사용하였으며 해당 모델을 임상에 적용하기에 학습시킨 데이터의 수가 적다는 한계점이 있었다. Ryu 등[16]의 연구에 의하면 과잉치의 평균 발거시기는 6.76세로 보고하였으며, 정중과잉치의 60%은 6 - 7세에 가장 높은 비율로 진단된다고 하였다. 따라서 이번 연구는 선행연구에 비해 과잉치 진단의 임상상황에 적합한 만 5, 6, 7세 환자를 샘플로 선택하여 유치열기와 혼합치열기의 데이터를 사용하여 해부학적으로 복잡한 구조물의 진단을 수행을 했다는데 의미가 있다. 또한 선행연구의 전체 데이터(n = 550)에 비해 약 2.9배의 데이터(n = 1604)를 활용하여 모델 훈련을 진행하였다. 뿐만 아니라 선행연구는 코딩을 통해 모델을 학습하였기 때문에 임상가의 접근성이 떨어진다는 단점이 존재하였다. 반면 이번 연구에 사용된 Teachable machine ver. 2.0은 사전 전문 지식이 필요하지 않으며 코딩 없이 필요한 모델을 만들 수 있다. 이를 통해 임상의사가 빠르고 쉽게 기계 학습 모델을 만들 수 있다는 장점이 있다.

하지만 이번 연구는 다음과 같은 한계점이 있다. 이번 연구는 단일 기관의 파노라마 영상을 이용했기 때문에 범용성에 제한이 있다. 향후, 타기관의 파노라마 영상을 확보하여 객관적인 평가를 통해 모델의 일반화 성능을 높일 수 있을 것이라 생각된다. 대부분의 전이학습 모델을 적용하는 연구들은 같은 모델을 사용하더라도 적용될 데이터 도메인과 추출된 특징에 따라 최적화된 분류 성능을 얻기 위해 맞춤형의 미세조절(fine tuning) 과정을 진행한다[3,17-20]. 이번 연구에서는 조절 가능한 3개의 매개변수(hyper-parameter; epoch, batch size, learning rate)만을 사용하여 학습과정과 성능평가를 시행하였기 때문에 미세 조절을 통한 분류 성능 향상에 제한적이었다. 또한, 인간집단과 모델의 비교 연구 시 포함된 평가자의 수가 적어 대표성에 한계가 있으며, 관찰자 간의 경험적 차이를 반영하는 지표를 포함하지 못했다. 이를 위해 전공 및 임상 경험에 따라 관찰자를 선정하여 연구를 진행할 필요가 있다.

향후 연구를 위한 제안점은 다음과 같다. 이번 연구에서는 분류작업을 단순히 과잉치의 존재에 따라 이분법적(binary classification)으로 시행하였지만 실제 과잉치의 분포는 개수와 모양 그리고 위치에 따라 다양한 분류가 가능하다. Multi-class learning을 위해서는 세분화된 분류에 따라 더 많은 데이터가 필요하며 추가적인 주석(annotation) 작업이 추가적으로 필요하다.

또한 Class activation map(CAM)을 이용해 모델의 설명을 시각화 할 수 있다[3,19,20]. 파노라마 영상에서 과잉치의 존재유무를 파악하는 것도 중요하지만 객체탐지모델 또는 CAM을 활용하여 과잉치의 위치까지 찾아서 모델의 분류성능을 임상에 적합하게 설명해 줄 수 있는 모델에 대한 연구들도 필요할 것이다.

Ⅴ. 결 론

이번 연구는 유치열기 및 초기 혼합치열기 어린이의 파노라마 방사선 영상과 웹 기반 기계 학습 어플리케이션 이용하여 과잉치 식별 모델을 개발하였고 학습된 모델과 인간집단(전공의 및 학생) 간의 과잉치 식별 정도를 비교 연구하였다. 훈련모델의 분류 정확도(0.78)는 전공의군(0.82)과 비교 시 낮았지만, 인간집단과 비교하였을 때 작은 편차 및 높은 재현성을 나타내었다. 또한 치과 대학 학생군(0.69)보다 분류 정확도(0.78)가 높아 비전문가 학생 또는 일반의사들에게 과잉치 진단 정확도를 높이는 데 활용될 가능성이 있음을 확인하였다.