1. Pitts NB, Zero DT, Ismail A,

et al. : Dental caries.

Nat Rev Dis Primers, 3:17030, 2017.

2. Featherstone JD : The science and practice of caries prevention.

J Am Dent Assoc, 131:887-899, 2000.

4. Selwitz RH, Ismail AI, Pitts NB : Dental caries. Lancet. 51-59, 2007.

5. Eli I, Weiss EI, Kaffe I, et al. : Interpretation of bitewing radiographs. Part, 24:379-383, 1996.

6. Weiss EI, Tzohar A, Eli I,

et al. : Interpretation of bitewing radiographs. Part 2. Evaluation of the size of approximal lesions and need for treatment.

J Dent, 24:385-388, 1996.

7. Akkaya N, Kansu O, Arslan U,

et al. : Comparing the accuracy of panoramic and intraoral radiography in the diagnosis of proximal caries.

Dentomaxillofac Radiol, 35:170-174, 2006.

8. Schwendicke F, Tzschoppe M, Paris S : Radiographic caries detection: A systematic review and meta-analysis.

J Dent, 43:924-933, 2015.

9. Chan HP, Hadjiiski LM, Samala RK : Computer-aided diagnosis in the era of deep learning. 47:218-227, 2020.

10. Russel S, Norvig P : Artificial intelligence: a modern approach. 4th ed. Pearson, Hoboken, 1-5, 2021.

11. LeCun Y, Bengio Y, Hinton G : Deep learning.

Nature, 521:436-444, 2015.

12. Rusk N : Deep learning.

Nature Methods, 13:35-35, 2016.

13. Albawi S, Mohammed TA, Al-Zawi S : Understanding of a convolutional neural network.

2017 International Conference on Engineering and Technology (ICET), 2017:21-23, 2017.

14. Zaremba W, Sutskever I, Vinyals O : Recurrent neural network regularization. ArXiv, abs:1409.2329-23, 2014.

15. Howard J, Gugger S : Fastai: A Layered API for Deep Learning.

Information, 11:108, 2020.

16. Paszke A, Gross S, Chintala S, et al. : Pytorch: An imperative style, high-performance deep learning library. Adv Neural Inf Process Syst, 32:8026-8037, 2019.

17. Schneiderman A, Elbaum M, Driller J,

et al. : Assessment of dental caries with Digital Imaging Fiber-Optic Translllumination (DIFOTI): in vitro study.

Caries Res, 31:103-110, 1997.

18. Lussi A, Hibst R, Paulus R : DIAGNOdent: An optical method for caries detection.

J Dent Res, 83:80-83, 2004.

19. ├ćal─▒┼¤kan Yan─▒ko─¤lu F, ├¢zt├╝rk F, Stookey GK,

et al. : Detection of natural white spot caries lesions by an ultrasonic system.

Caries Res, 34:225-232, 2000.

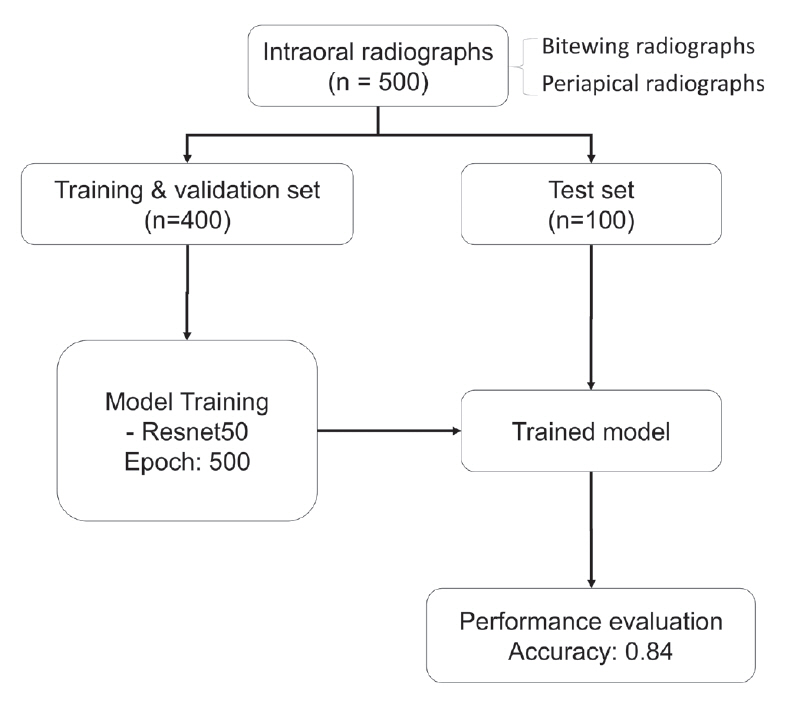

20. Lee JH, Kim DH, Jeong SN, Choi SH : Detection and diagnosis of dental caries using a deep learning-based convolutional neural network algorithm.

J Dent, 77:106-111, 2018.

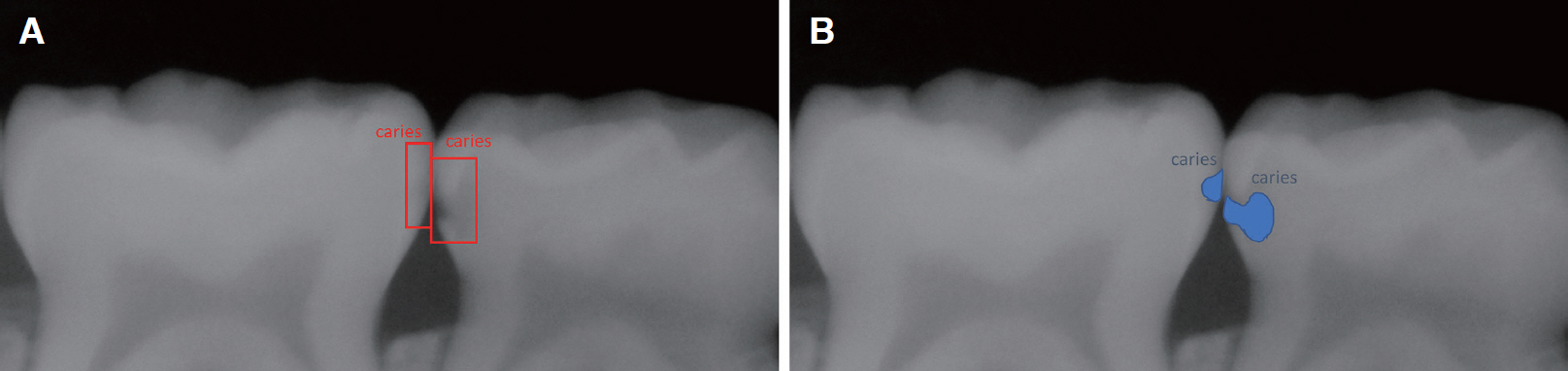

21. Cantu AG, Gehrung S, Schwendicke , F ,

et al. : Detecting caries lesions of different radiographic extension on bitewings using deep learning.

J Dent, 100:103425, 2020.

23. Lee S, Oh SI, Park JW,

et al. : Deep learning for early dental caries detection in bitewing radiographs.

Sci Rep, 11:16807, 2021.

24. Kamburoglu K, Kolsuz E, Ozen T,

et al. : Proximal caries detection accuracy using intraoral bitewing radiography, extraoral bitewing radiography and panoramic radiography.

Dentomaxillofac Radiol, 41:450-459, 2012.

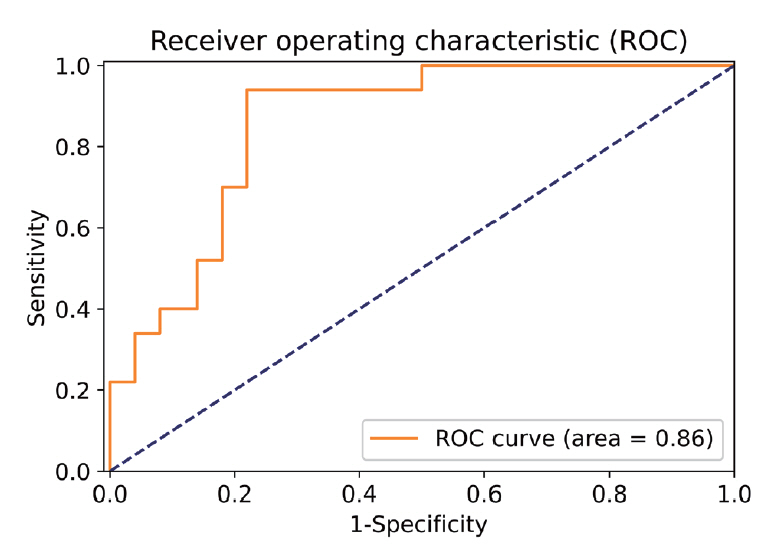

25. Muller MP, Tomlinson G, Gold WL,

et al. : Can routine laboratory tests discriminate between severe acute respiratory syndrome and other causes of community-acquired pneumonia.

Clin Infect Dis, 40:1079-1086, 2005.

26. Krois J, Garcia Cantu A, Schwendicke , F ,

et al. : Generalizability of deep learning models for dental image analysis.

Sci Rep, 11:6102, 2021.

PDF Links

PDF Links PubReader

PubReader ePub Link

ePub Link Full text via DOI

Full text via DOI Download Citation

Download Citation Print

Print