유치의 치근단 방사선 사진에서 딥 러닝 알고리즘을 이용한 모델의 인접면 우식증 객체 탐지 능력의 평가

Assessment of the Object Detection Ability of Interproximal Caries on Primary Teeth in Periapical Radiographs Using Deep Learning Algorithms

Article information

Abstract

이 연구의 목적은 소아의 치근단 방사선 사진에서 인접면 우식증 객체 탐지 의 객체 탐지를 위해 YOLO (You Only Look Once)를 사용한 모델의 성능을 평가하는 것이다. M6 데이터베이스에서 학습자료군으로 2016개의 치근단 방사선 사진이 선택되었고 이 중 1143개는 한 명의 숙련된 치과의사가 주석 도구를 사용하여 인접면 우식증을 표시하였다. 표시한 주석을 데이터 세트로 변환한 후 단일 합성곱 신경망(CNN) 모델을 기반으로 하는 YOLO를 데이터 세트에 학습시켰다. 187개의 평가자료군에서 객체 탐지 모델 성능 평가를 위해 정확도, 재현율, 특이도, 정밀도, NPV, F1-score, PR 곡선 및 AP를 계산하였다. 결과로 정확도 0.95, 재현율 0.94, 특이도 0.97, 정밀도 0.82, NPV 0.96, F1-score 0.81, AP 0.83으로 인접면 우식증 탐지에 좋은 성능을 보였다. 이 모델은 치과의사에게 치근단 방사선 사진에서 인접면 우식증 병변을 객체 탐지하는 도구로 유용하게 사용될 수 있다.

Trans Abstract

The purpose of this study was to evaluate the performance of a model using You Only Look Once (YOLO) for object detection of proximal caries in periapical radiographs of children. A total of 2016 periapical radiographs in primary dentition were selected from the M6 database as a learning material group, of which 1143 were labeled as proximal caries by an experienced dentist using an annotation tool. After converting the annotations into a training dataset, YOLO was trained on the dataset using a single convolutional neural network (CNN) model. Accuracy, recall, specificity, precision, negative predictive value (NPV), F1-score, Precision-Recall curve, and AP (area under curve) were calculated for evaluation of the object detection model’s performance in the 187 test datasets. The results showed that the CNN-based object detection model performed well in detecting proximal caries, with a diagnostic accuracy of 0.95, a recall of 0.94, a specificity of 0.97, a precision of 0.82, a NPV of 0.96, and an F1-score of 0.81. The AP was 0.83. This model could be a valuable tool for dentists in detecting carious lesions in periapical radiographs.

서론

치아우식증은 플라그 내의 미생물에 의해 치아의 경조직에 영향을 미치는 국소적인 질환이다[1]. 가장 흔한 구강질환 중 하나로서, 우식증의 정확한 진단은 임상적으로 매우 중요하다. 시각 및 촉각 검사는 우식증 병소를 감지하는 표준 방법이지만, 치간부위는 접촉 면적이 넓어 시각 및 촉각 검사만으로는 우식증 병변을 정확히 감지하는 데는 한계가 있다[2]. 우식증 진단 시 구내 방사선 사진은 임상에서 가장 일반적으로 사용되는 방법이다[3]. 구내 방사선사진으로는 파노라마, 교익방사선사진, 치근단방사선사진이 있으며[4], 유치열기 우식증 진단에서 가장 많이 추천되는 방사선 사진은 교익방사선 사진과 치근단방사선사진의 병용이다[5]. 그러나, 구강이 작고 행동조절이 어려운 소아에서는 필름의 위치를 잡는 것이 어려울 뿐만 아니라 참을성이 떨어지고 불안이 커져 교익방사선사진을 취하는 것이 어렵다[6,7]. 따라서, 임상에서는 소아의 구내 방사선 사진으로 치근단 방사선 사진을 주로 활용하나, 촬영 각도에 따른 상의 연장, 축소, 인접면 중첩 등으로 인해 정확한 우식증 진단에 어려움이 있다[8].

전 세계 의료 분야에서 인공지능의 적용에 대한 연구가 최근 수년간 빠르게 진행되고 있다. 이러한 연구의 핵심은 인공지능이 ‘사람처럼 행동하는 장치’로서의 역할을 이해하고 이를 의료 분야에 적용하는 것이다. 이 인공지능의 한 분야가 바로 ‘머신 러닝’으로, 이는 다량의 데이터를 학습하고 이를 통해 예측 또는 결정을 내리는 능력을 갖춘 알고리즘을 찾는 과정이다. 머신 러닝의 한 분야인 ‘딥 러닝’은 머신 러닝에 인간의 논리 구조를 더한 기술로, 인공 신경망이 이에 해당한다. 딥 러닝은 인간이 학습데이터를 직접 입력하지 않아도, 알고리즘이 자체적으로 학습하고 예측을 수행할 수 있다[9]. 딥 러닝의 한 방법론인 CNN (Convolutional Neural Networks)은 특히 의료 영상 분석에서 활용되고 있다. CNN은 포유류의 시각 피질에서 영감을 받은 신경망으로, 이를 통해 병소 진단이 가능하다[10]. 이미지 분류(classification), 객체 탐지(object detection), 분할(segmentation) 등의 작업을 수행하는 모델에서 CNN은 특히 유용하게 사용된다[11].

YOLO (You Only Look Once)는 워싱턴 대학의 Joseph Redmon과 Ali Farhadi가 개발한 객체 탐지 모델로, 단일 합성곱 신경망(CNN)을 기반으로 이미지나 영상에서 객체의 분류와 위치를 동시에 예측한다[12]. YOLO의 특징적인 점은 세 가지로 나뉜다. 첫째, 이미지를 한 번만 보고도 분석이 가능하다. 둘째, 전처리 모델과 인공신경망을 분리한 기존의 방식이 아니라, 둘을 통합한 모델을 사용한다. 셋째, 실시간 객체 탐지가 가능하며, 기존의 R-CNN 모델보다 처리 속도가 6배 빠르다. 이러한 특성들 덕분에 YOLO는 실시간 객체 감지, 자율주행차, 로봇 공학 등 다양한 분야에서 빠르고 정확한 성능을 위해 적용되고 있다.

임상 환경에서는 인접면 우식증을 실시간으로 탐지하고 결과를 신속하게 제공해야 하며, 높은 진단 신뢰성이 요구된다. 더불어, 단일 사진에서 다양한 우식증을 동시에 감지하는 능력 또한 필요하다. 한 장의 이미지를 여러 장으로 분할 후 분석하는 기존의 DPM, R-CNN과 비교했을 때, YOLO 알고리즘은 이미지를 한 번만 스캔하여 빠른 처리 속도를 보여주며, 부분적인 분석이 아닌 전체 이미지를 한 번에 처리함으로써 더 넓은 컨텍스트를 포착하고 정확성을 높인다[12,13]. 이러한 특성들은 YOLO가 여러 인접면 우식증을 신속하게 탐지하고 진단 신뢰성을 높이는 데 있어서 독특한 장점을 가지고 있다.

YOLO의 주요 측면 중 하나는 입력 이미지에서 개체의 위치를 예측하는 데 사용되는 Bounding box를 사용한다는 것이다. 이를 통해 좌표, 카테고리 정보를 입력받고, 객체의 바운딩 박스 좌표와 카테고리를 출력하게 된다. YOLO 모델은 PyTorch에서 구현되며 GitHub의 오픈 소스 YOLO repository를 통해 사용할 수 있다.

전이 학습은 머신 러닝의 핵심 기술 중 하나로, 학습 데이터가 부족한 상황에서도 모델을 효과적으로 학습시키는 방법을 제공한다. 이 방법은 이미 대규모 데이터에서 사전 훈련된 모델의 지식을 새로운 작업에 적용하여, 학습 데이터가 적은 경우에도 높은 성능을 달성할 수 있게 한다. YOLO의 5번째 버전인 YOLOv5는 이러한 전이 학습을 활용하는 대표적인 모델로, 사전 훈련된 모델을 사용하여 한정된 학습 데이터로도 우수한 성능을 보여준다. 본 연구에서는, YOLOv5의 정확도를 높인 YOLOv5 XLarge 모델을 사용하여 전이 학습을 시행하였다.

객체 탐지 모델(object detection model)은 컴퓨터 비전과 영상 처리 분야에서 딥 러닝을 활용한 핵심 기술이다. 이 모델은 입력된 이미지나 영상에서 존재하는 모든 객체를 분류하고 위치를 파악한다. 분류는 물체가 무엇인지를 결정하고, 위치 파악은 해당 물체의 위치를 찾아낸다[14]. 모델의 학습에 따라, 특정 객체를 탐지하거나 여러 개의 객체를 동시에 탐지할 수 있다[15].

지금까지의 연구에서는, 인공지능을 이용하여 소아의 유구치 인접면 우식증을 진단하는 경우, 대부분 교익방사선사진에서 유치의 인접면 우식증 병소를 분류하는 방법에 초점을 맞추었다[16]. 이 방식은 우식증의 존재 유무만을 파악할 수 있으며, 객체의 위치 정보는 제공하지 않는다. 또한, 치근단방사선사진과 같이 촬영 방향에 따라 왜곡이 발생하는 이미지에 대한 연구는 매우 부족하다.

따라서 본 연구는 객체 탐지 모델 중 하나인 You Only Look Once (YOLO) 모델을 이용하여 소아의 치근단방사선사진에서 인접면 우식증 영역을 학습하고 성능 평가하는 것을 목표로 한다. 그리고 추후 소아치과의 우식증 진단 보조도구로서의 활용성에 대하여 알아보고자 한다.

연구 재료 및 방법

본 연구는 전남대학교의 생명윤리심의위원회(Institutional Review Board, IRB)의 심의를 통과한 후 시행되었다(IRB No: CNUDH-2023-012).

1. 연구 대상

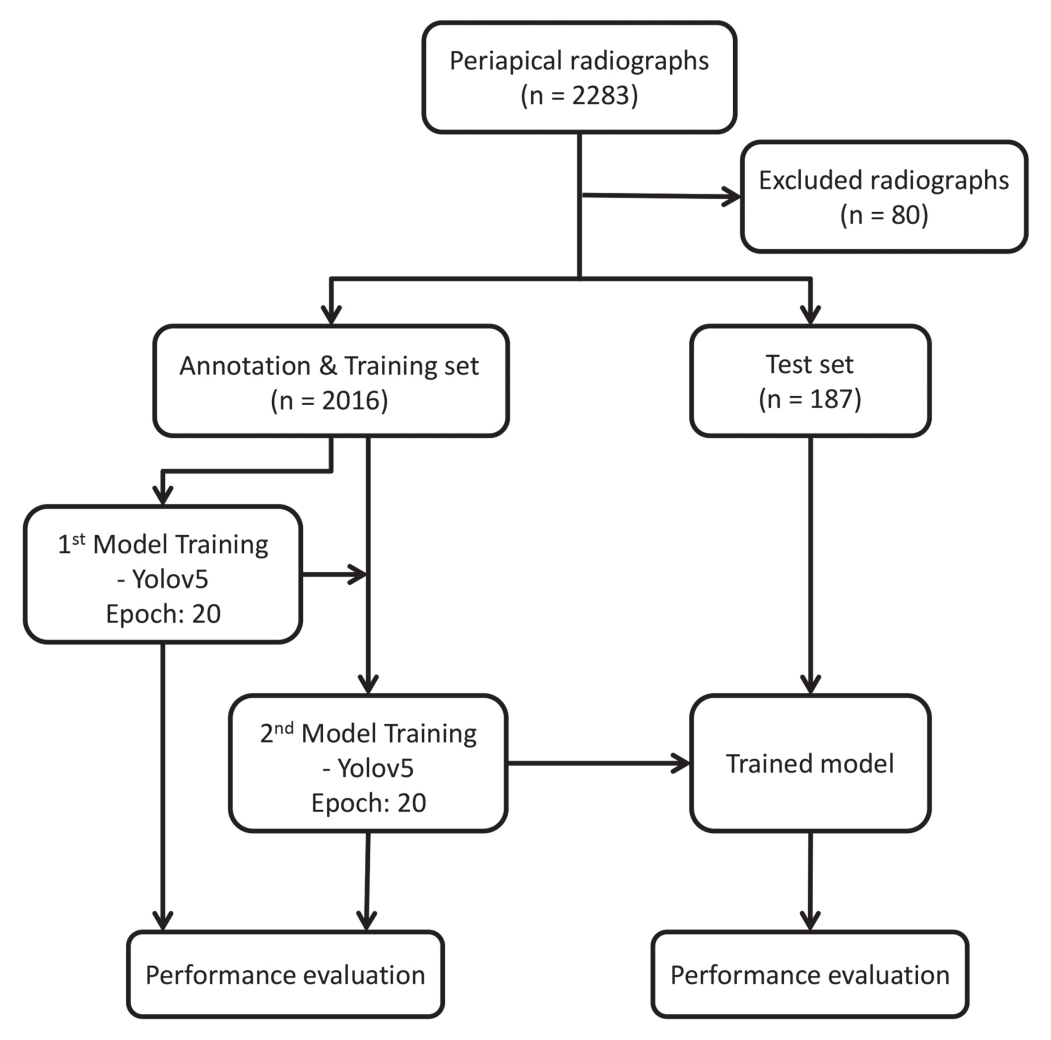

2017년 1월부터 2022년 8월까지 전남대학교 소아치과에서 우식증 진단 및 치료를 위해 촬영하고 INFINITT M6 (INFINITT Healthcare Co., Ltd, Seoul, Korea) PACS 시스템에 DICOM 형식으로 저장된 치근단 방사선 사진 2283개를 수집하였다. 환자에 대한 추가 정보(예: 성별, 연령 또는 기타 임상 정보) 없이 최소 제1, 2유구치를 포함하는 치근단 방사선 사진이 데이터에 사용되었다. 이번 연구는 실제 임상 상황에서 촬영하는 사진과 최대한 유사하고 다양한 사례를 포함하기 위해 인접면 중첩이나 조사통 가림이 있는 사진도 포함했다. 치아 위치에 따른 결과값의 편향성을 방지하기 위하여, 상악과 하악 이미지의 비율이 최대한 동일하도록 데이터 수집을 진행하였다. 특정 치아의 해부학적 배열로 인해 낮은 이미지 품질, 과도한 왜곡이 있는 방사선 사진은 정확한 우식증 진단에 방해가 될 수 있으므로 이에 해당되는 80개의 사진이 제외되었다. 치근단 방사선 사진은 치과용 X선 기계(Kodak RVG 6200 Digital Radiography System with CS 2200; Carestream, Rochester, USA)를 사용하여 촬영되었다.

2. 연구 방법

1) 자료의 전처리(Pre-processing)

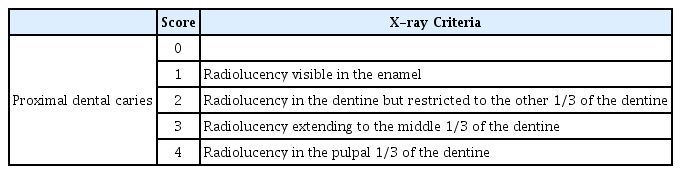

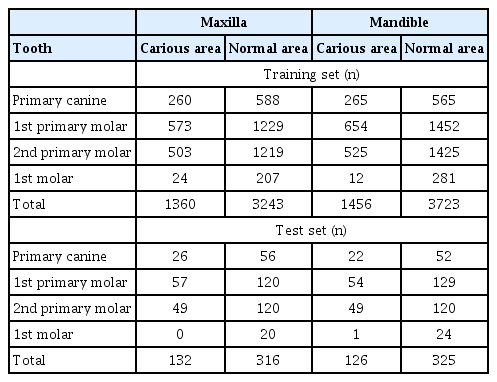

데이터 수집 단계에서는 인접면 우식증의 유무에 따라 사진들이 분류되었다. 우식증은 인접해 있는 치아의 근원심 우식증 및 치간공극이 있는 치아의 근원심, 인접치가 없는 치아의 근원심까지 포함하였다. 인접면 우식증이 있는 사진은 우식증 영역을 표시하는데 사용되었다. 한 명의 방사선과 전문의와 두 명의 치과의사가 의견을 일치시켜, 수집된 2283개의 사진에서 80개의 사진을 제외한 2203개의 사진을 대상으로 인접면 우식증이 있는 1143개의 방사선 사진을 선택하였다. 인접면 우식증의 진단기준으로는 American Dental Association Caries Classification System (ADA CCS)[17]을 사용하였다(Table 1). 그 중 인접면 우식증은 없으나(score 1) 인접치와 중첩이 있는 방사선 사진의 경우 착시(Optical illusion) 현상으로 인하여 판독 시 법랑질에 국한된 인접면 우식증 (score 1)으로 위양성 오류를 유발할 수 있다. 이를 보완하기 위해 대상자의 임상적 증거 및 진료기록을 확인하여 실제 우식증 유무를 확인하였다. 이 과정을 통해 데이터의 정확성을 높였다. 이 과정을 거친 후 사진들을 학습자료군과 평가자료군으로 상악과 하악, 우식증과 정상의 비율을 자료군간에 최대한 비슷하도록 분포시켰다(Table 2). 이를 바탕으로 자료군의 치아별 인접면의 개수(Table 3), 치아별 우식증 영역 및 정상 영역의 분포를 조사하였다(Table 4).

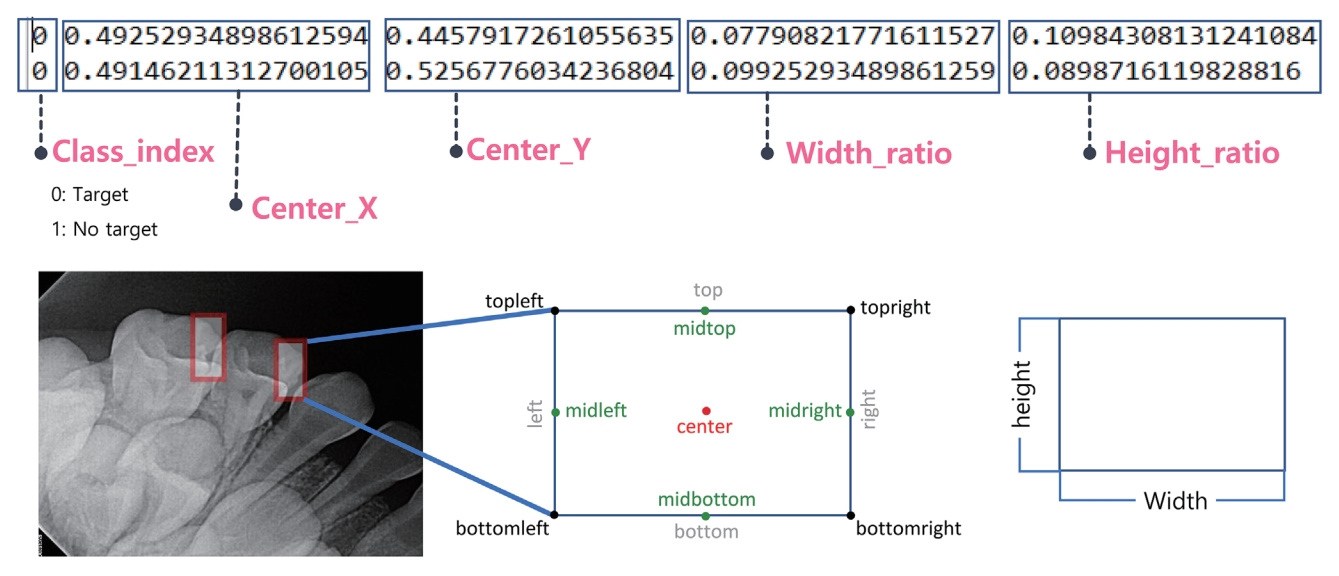

한 명의 치과의사가 GUI 환경에서 Drag & Drop으로 우식증 영역을 표시할 수 있는 라벨링 도구인 LabelImg[18]을 사용하여 ADA CCS score 1 - 4로 우식증이 있는 치근단방사선사진에서 모든 치아의 인접면 우식증에 bounding box를 표시하였다. 객체인식에서 bounding box는 직사각형 모형이지만 실제 인접면 우식증은 모양이 다양하기 때문에 영역 표시의 기준을 설정하였다. 인접면 우식증의 패턴을 정확히 학습시키기 위해서는 우식증 범위를 최대한 포함해야 하므로, 우식증 영역의 방사선투과상의 좌우 끝점을 연결한 선을 가로선, 상하 끝점을 연결한 선을 세로선으로 한 직사각형 bounding box를 설정하였다(Fig. 1A). 수복물 하방의 인접면 2차 우식증의 경우도 마찬가지로 수복물의 범위에 상관없이 2차 우식증 부위의 방사선투과상을 최대한 포함시킬 수 있도록 하였다(Fig. 1B). ADA CCS score 2나 3중에 법랑질에 국한된 score 1을 동반하는 경우, 법랑질에 국한된 우식증 영역과 법랑질과 상아질을 모두 포함하는 우식증 영역 두 개를 표시하였다(Fig. 1B). 촬영 각도로 인하여 중첩된 사진의 경우, 중첩을 포함한 우식증 영역도 학습시킬 목적으로 중첩영역에 관계없이 각 치아별로 우식증 부위를 모두 포함하도록 하였다(Fig. 1C). 그 후에 한 명의 치과의사와 평가 결과를 공유하여 일치하지 않는 경우에 대해 토의 후 수정하였다. 이 과정을 통해 진단의 신뢰성 및 일치도를 높이고자 하였다. 우식증 영역은 target으로 표시하였고, ADA CCS score 0으로 우식증이 없는 정상 이미지는 이미지 영역 전체를 no_target으로 표시하였다(Fig. 2). 치근단 방사선 사진은 각도에 따른 중첩이 빈번하므로, 우식증 영역만 학습할 경우 위양성이 많이 인식될 것으로 예상되어 no_target 영역을 별도로 지정해 구분하여 학습할 수 있도록 하였다. 다음으로 라벨링 한 데이터를 증강(Data Augmentation) 시키는 과정을 거쳤다[19]. 방식으로는 이미지 회전을 사용하였고 각각 90.0°, 180.0°, 270.0° 회전시켰다. 이후 Bounding box 데이터를 YOLOv5용 학습 데이터로 변환(Data conversion)시키는 과정을 거쳤다. 객체 탐지에서는 bounding box의 데이터를 변환 시 center 혹은 corner 두 가지의 좌표를 사용하는데, 이번 연구에서는 우식증에 따라 bounding box의 크기와 종횡비가 변화하는 특성을 고려하여 center coordinates를 사용하였다(Fig. 3)[12].

Establishing bounding box parameters for diverse caries patterns. (A) a: Horizontal line, b: Vertical line, (B) a: Secondary caries, b: ADA CCS score 1, c: ADA CCS score 3, (C) Superimposed X-ray.

2) 모델의 학습 및 평가

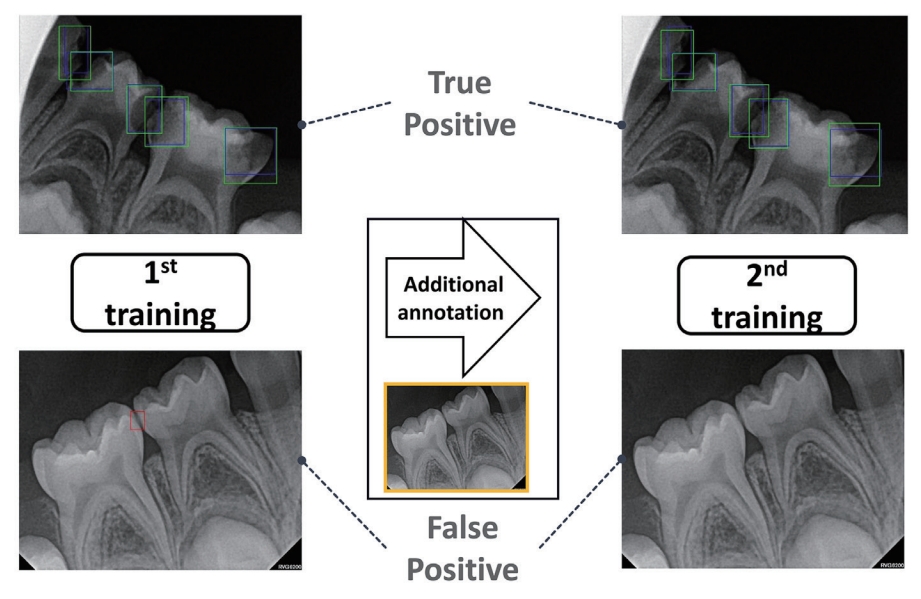

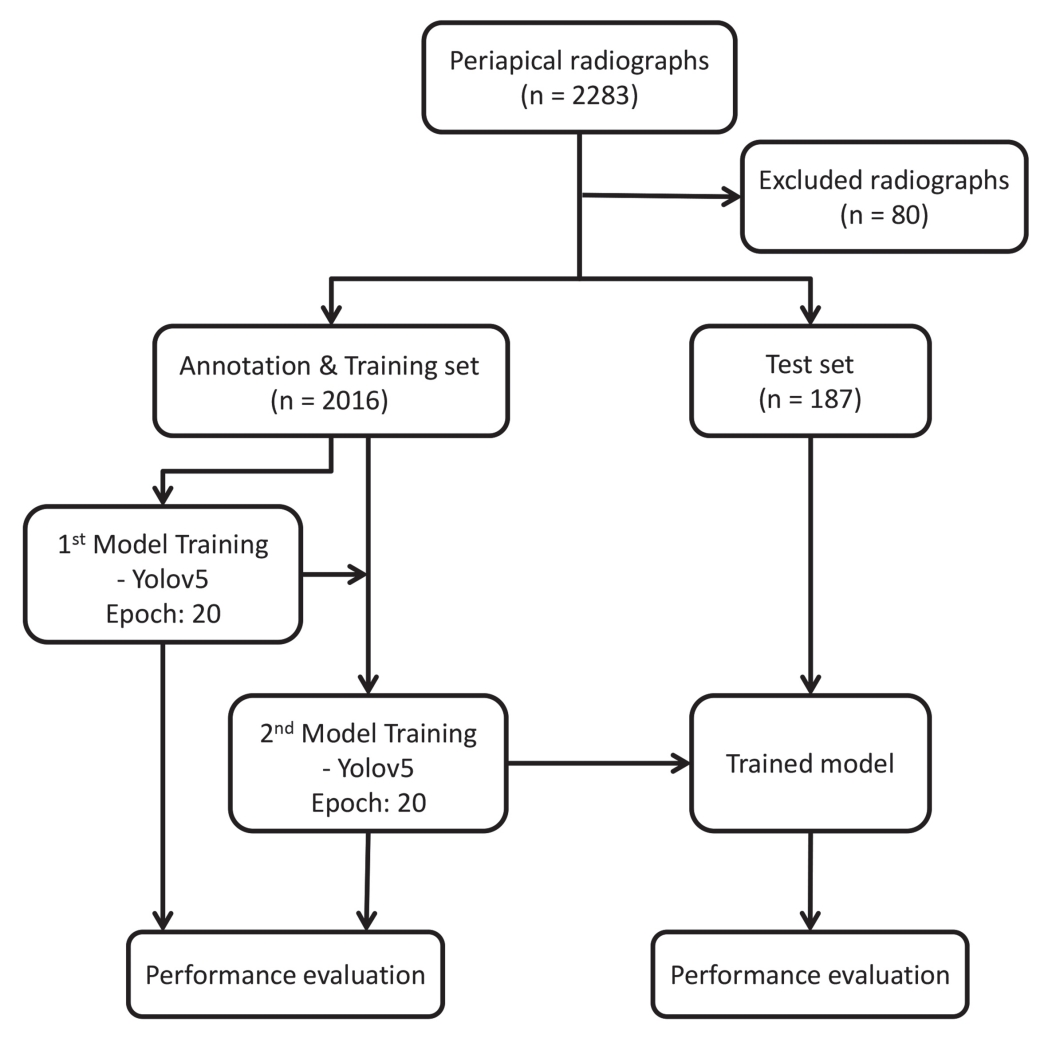

이번 연구에서는 2016개의 치근단 사진을 학습 자료군으로 하여 모델 훈련을 시행하였고, 모델의 학습은 YOLOv5 Xlarge pre-trained model을 활용하여 epoch: 20 하에서 전이 학습시켰다. 이는 전체 데이터를 20번 반복 학습을 시키라는 의미이다. 첫 번째 학습 모델을 같은 학습 자료군으로 성능평가 후, 결과값에서 위양성으로 우식증을 인식한 자료를 따로 선별하여 수정 후 재학습시켰다. 이를 2차 학습 모델로 하여 같은 학습 자료군으로 성능평가 하였다. 마지막으로 187개의 치근단 사진을 평가 자료군으로 하여 2차 학습 모델로 성능평가를 진행하였다(Fig. 4).

IoU (Intersection Over Union) threshold는 객체 탐지의 정확도를 평가하는 지표로서[20], IoU는 판단 결과의 경계 영역과 실제 객체의 경계 영역이 겹치는 정도의 비율을 결정하기 위한 역치값을 요구한다. 일반적으로 역치값은 0.5를 사용한다[21]. 판단 결과 및 실제 객체의 경계 영역이 겹칠 때, 역치값이 0.5 이상이면 True Positive로 판단하고 0.5 이하면 False Positive 값으로 판단한다. 이번 연구에서도 IoU threshold 값으로 0.5를 사용하였다.

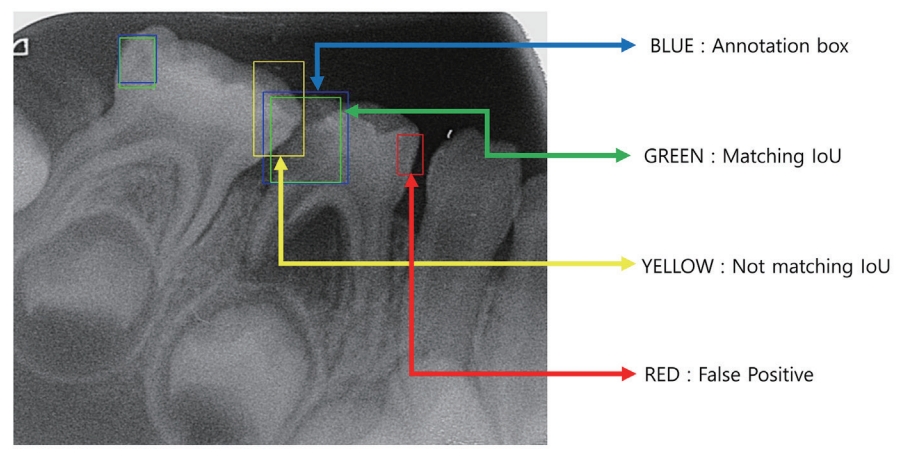

첫번째 학습 모델을 학습자료군으로 성능평가하였다. 평가 후 결과 이미지에서 각각 청색, 녹색, 황색, 적색으로 박스가 표시되는데, 청색은 annotation시 우식증으로 표시한 bounding box이고, 녹색은 탐지영역과 우식증 영역이 IoU 역치값을 만족시키면서 겹칠 때 나타나는 box이다. 반대로 황색은 탐지 영역과우식증 영역이 일부 겹치지만 IoU 역치값을 만족시키지 않는 box이다. 적색은 위양성(False Positive)이다(Fig. 5).

치근단 방사선 사진에서는 촬영 각도에 따른 인접면 중첩이 나타나 우식증 진단에 정확도가 하락하는데[9], 이 위양성 영역이 인접면 중첩으로 인해 발생하였다. 학습 모델의 정확도를 높이기 위해, 학습 자료군에서 위양성 영역을 선별하여 no_ target으로 추가 annotation을 실행하였고(Fig. 6), 같은 학습 자료군으로 1차 학습과 같은 방식을 통해 2차 학습을 실시하였다. 그 후 동일한 학습자료군으로 성능평가를 진행하였다.

두번째 학습 모델을 이용하여 학습 자료군에 포함되지 않은 187개의 치근단사진 평가 자료군에 대하여 테스트를 진행하였고, 그 결과를 두 가지로 나누어 분석하였다. 첫번째는 방사선 사진 전체에 대한 우식증 탐지의 정확도를 구하였고, 두번째는 모든 인접면에 대한 우식증 탐지 성능평가를 진행하였다.

프로그래밍 언어는 Python을 사용하였고 딥 러닝 프레임워크는 Pytorch를 사용하였으며 학습 및 평가 과정은 Nvidia Tesla K80 GPU 환경을 제공하는 Google Collaboratory 원격 클라우드 컴퓨터에서 시행하였다.

3) 통계분석

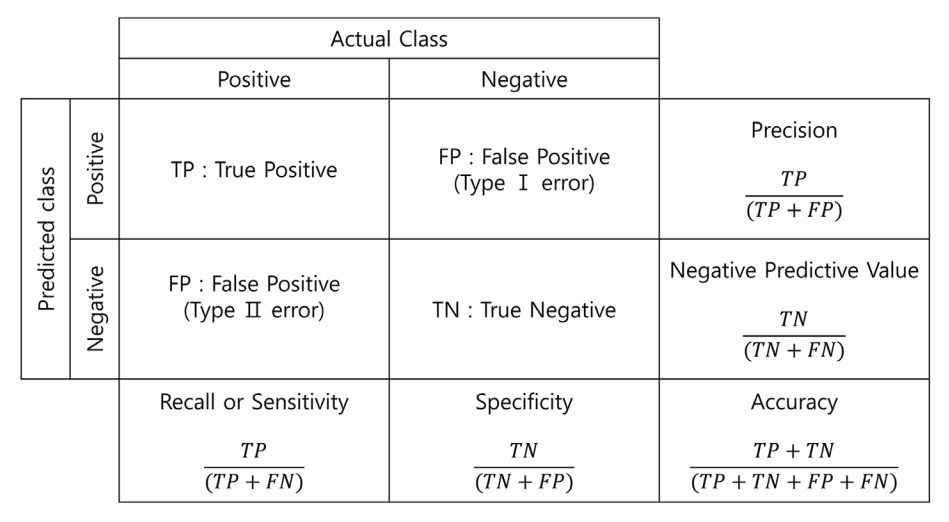

딥 러닝 모델에 대한 성능지표는 다음과 같다(Fig. 7)[22]. 이번 학습 모델은 객체 탐지 모델로서 성능평가를 위해 true positive (TP), true negative (TN), false positive (FP), false negative (FN)를 구하고 오차 행렬(confusion matrix)을 계산 후, 이를 바탕으로 정밀도(precision), NPV (Negative Predictive Value), 재현율(recall), 특이도(specificity), 정확도(accuracy), F1-score를 구하였다. 이 중 객체 탐지 모델의 성능 평가는 주로 정밀도와 재현율을 기반으로 한 Precision-Recall curve (PR curve)를 이용한다[23]. 2차 학습 모델로 평가 자료군에 대해 성능 평가한 데이터 값을 기반으로 PR 곡선을 구한 후 곡선의 아래 면적인 Average Precision (AP) 값을 측정하여 평가하였다. 통계 프로그램으로는 SPSS 23.0.0 (IBM Corporation, Armonk, NY, USA) 소프트웨어 프로그램과 머신 러닝 분석 시 사용되는 Python library인 Scikit-learn package v1.0.2[24,25]를 이용하여 통계적 분석을 수행하였으며, N-1 카이제곱 검정을 사용하였다[26,27].

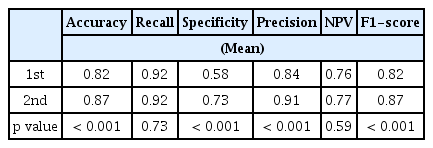

연구 성적

치근단 방사선사진 2016개로 이루어진 학습 자료군을 대상으로 1차, 2차 학습 모델을 평가하였을 때의 검증 결과 비교이다(Table 5). 정확도, 재현율, 특이도, 정밀도, NPV, F1-score는 각각 1차는 0.82, 0.92, 0.58, 0.84, 0.76, 0.82였고 2차는 0.87, 0.92, 0.73, 0.91, 0.77, 0.87로 나타났다. 두 모델의 성능지표 비교 결과 1차 학습 모델에 비해 2차 학습 모델에서 정확도, 특이도, 정밀도, F1-score에 유의미한 증가가 나타났다.

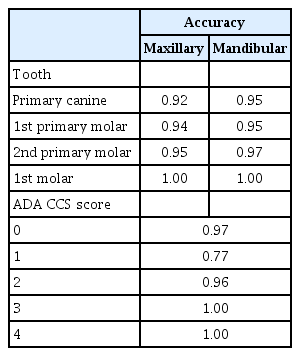

학습 자료군에 포함되지 않은 187개의 치근단방사선사진으로 이루어진 평가 자료군을 대상으로 2차 학습 모델의 성능을 평가하였다. 첫 번째는 방사선 사진 전체에 대한 우식증 탐지의 정확도로, 만약 사진에 나타난 인접면 우식증이 3곳이라면 모두 정확하게 예측해야 ‘정확한 예측’으로 간주하였다. 하나라도 틀린 경우에는 ‘오류 예측’으로 분류하였다. 그 결과 정확한 예측은 160개, 오류 예측은 27개로, 정확도는 0.86이 나왔다(Table 6). 두 번째로 인접면 개수에 대한 우식증 탐지 성능평가를 시행하였고 이에 대한 결과를 오차 행렬로 표시하였다. 모델이 실제 우식증 부위를 IoU 역치값 안으로 예측한 영역은 234개, 정상 부위를 우식증으로 잘못 예측한 영역은 14개, 우식증 부위를 예측하지 못한 영역은 24개, 정상 부위를 정상으로 예측한 영역은 627개로, 187개의 사진에서 총 899개의 모델 예측 영역을 도출하였다(Fig. 8). 이 오차 행렬을 바탕으로, 정확도, 재현율, 특이도, 정밀도, NPV, F1-score는 각각 0.95, 0.94, 0.97, 0.82, 0.96, 0.81로 나타났다(Table 7). 각각의 치아 종류에 대한 정확도 평가, 즉 유견치, 제 1, 2유구치 및 제 1대구치에 대한 평가에서는 상악은 각각 0.92, 0.94, 0.95, 1.00이며 하악의 정확도는 0.95, 0.95, 0.97, 1.00이었다. 또한 우식증의 진행 정도에 따른 정확도 평가에서, ADA CCS score가 0점일 때 0.97, 1점일 때 0.77, 2점일 때 0.96, 그리고 3점과 4점은 각각 1.00이었다(Table 8).

PR 곡선은 다양한 임계값에서 모델의 객체 탐지 성능에 대한 측정 그래프이고, Average Precision (AP)는 PR 곡선 아래 영역으로서, AP가 높을수록 성능이 훌륭하다는 것을 의미한다.이 연구에서 AP의 값은 0.83으로 좋은 성능을 나타내었다(Fig. 9).

총괄 및 고찰

유구치의 인접면 우식증 진행 속도는 영구치보다 빠르다. 유구치는 법랑질 및 상아질의 두께가 얇고 인접면의 넓은 접촉면적으로 인해 치태의 축적이 쉬울 뿐만 아니라 영구치에 비해 광화가 덜 되어 있기 때문이다[28,29]. 그러나 초기 인접면 우식증은 임상적으로 탐침이나 육안으로 탐지하기가 어렵기 때문에 조기진단에 한계가 있다[30].

이로 인해 파노라마, 교익방사선사진, 치근단 방사선 사진과 같은 방사선 사진이 진단 보조 도구로 사용되고 있다. 더 나아가 최근에는 방사선 사진을 이용한 진단을 인공지능과 접목한 CAA (Computer-Aided Assist) 시스템의 연구가 활발히 이루어지고 있다. CAA 시스템은 경험이 부족한 치과의사가 방사선 사진에서 인접면 우식증 병소를 보다 신속하고 정확하게 평가하는 데 도움이 될 수 있다[31].

기존 연구는 주로 중첩이 없는 교익방사선 사진을 이용하였다. Srivastava 등[32]은 FCNN 인공신경망 모델을 사용하여 3000개의 교익방사선 사진상을 학습시켜 치아 우식증을 진단하는 능력을 평가하고 세 명의 치과의사군과 비교하였다. 모델의 재현율은 80.5%였고 정밀도는 61.5%였으며 F1-score는 70%이었다. Cantu 등[33]은 우식증 병소를 U-Net 인공신경망 알고리즘을 활용하여 3686개의 교익방사선사진을 학습시켜 이를 치과의사군의 진단 능력과 비교하였다. 그 결과 정확도는 0.80이었고 특이도는 0.83, 재현율은 0.75으로 학습된 인공신경망의 경우 재현율이 0.36인 치과의사군보다 더 높은 재현율을 보였다.

파노라마를 대상으로 딥 러닝을 활용한 우식증 진단 연구도 이루어지고 있다. Lian 등[34]은 1071개의 파노라마를 대상으로 U-Net 인공신경망 알고리즘을 사용하여 우식증 병변을 감지하도록 학습시켰고 DenseNet121 알고리즘을 적용하여 우식증 병변의 깊이에 따른 분류를 하도록 학습시켰다. 우식증 병변 감지 모델의 정확도 및 재현율은 각각 0.986 및 0.821이었다. 우식증 깊이 분류 모델의 경우 D1/D2/D3 병변에서의 정확도는 각각 0.957, 0.832, 0.863 이었고, 재현율은 각각 0.765, 0.652, 0.918이었다. 두 모델 모두 치과의사군의 진단 결과와 비교했을 때 정확도, 정밀도, 재현율, NPV, F1-score 면에서 유의미한 차이가 없는 것으로 나타났다. 대부분의 연구에서 학습 모델이 높은 정확도를 보였으나, 치근단 방사선 사진을 이용한 진단 모델의 연구는 부족하였다.

객체 탐지를 이용한 우식증 진단의 기존 연구로는 Bayraktar와 Ayan[31]이 CNN기반의 YOLO 모델을 사용하여 1000개의 교익방사선사진을 대상으로 영구치 인접면 우식증을 학습시켜 우식증을 객체 탐지하는 모델이 있다. 진단 모델의 성능으로 정확도는 0.94, 재현율은 0.72, 특이도는 0.98을 나타냈다. Lee 등[10]은 U-Net 인공신경망 알고리즘을 사용하여 304개의 교익방사선사진을 학습시켰고 50개 교익방사선사진상에서 치아 우식증을 이미지 분할(image segmentation)하는 모델을 개발 후 성능을 평가하였다. 정밀도는 63.29, 재현율은 65.02, 그리고 F1-score는 64.14이었다.

유치를 대상으로 딥 러닝을 이용한 우식증 진단 연구도 이루어지고 있다. Kim 등[16]은 Resnet50 기반의 인공신경망 모델을 이용하여 500개의 구내방사선 사진을 대상으로 치아우식증의 유무를 학습시켰다. 학습 모델의 정확도는 0.84, 재현율은 0.74, 특이도는 0.94로 나타났으며 AUC는 0.86으로 나타나 높은 정확도를 보여주었다.

이번 연구에서는 CNN 인공신경망 이론을 기반으로 한 YOLO 모델을 이용하여, 치근단 방사선 사진에서 나타나는 유치의 인접면 우식증 객체 탐지 모델을 설계하고 성능을 평가하였다. YOLO는 인접면 우식증 탐지에 있어 연구 결과 정확도는 0.95, 재현율은 0.94, 특이도는 0.97, 정밀도는 0.82, NPV는 0.96, F1-score는 0.81, AP는 0.83으로 나타났다. 전체 측정치 중에서 실제 값과 예측치가 일치하는 정도를 나타내는 정확도는 0.95로, 이는 우식증 진단 모델이 95%의 확률로 우식증 부위를 IoU 역치값을 만족시키는 객체 탐지를 시행했다는 뜻이다. 이는 유치를 대상으로 한 기존의 연구와 비슷한 정확도를 보였다[16]. 재현율은 0.94로, 이는 우식증이 존재하는 방사선 사진 중 모델이 IoU를 만족시키는 우식증 객체 탐지를 한 비율을 나타내며, 실제 우식증이 있는 사진에서 94% 확률로 우식증을 객체 탐지 하였다는 뜻이다. 이는 기존의 우식증 객체 탐지 연구보다 높은 수치를 나타내었다[34]. 정밀도는 0.82로 모델이 객체 탐지한 것 중 실제 우식증이 있는 비율을 뜻하며, 수치는 기존 연구들과 비슷한 경향성을 나타내었다[16,32,34]. NPV는 0.96으로 모델이 우식증이 없다고 판단한 것 중 실제 우식증이 없는 비율이다. F1-score는 0.81로, 일반적으로 점수가 0.8을 넘으면 정밀도와 재현율이 어느 한쪽으로 치우치지 않고 좋은 이진 분류기의 성능을 나타낸다[35]. 기존의 연구와 비교 시 비슷하거나[16,34] 더 뛰어난 경향성을 보였다[10,32]. AP값은 0.83으로, YOLOv5를 이용한 얼굴 마스크를 검출한 다른 연구와 비교 시 0.84로 본 연구와 유사한 값을 보였다[36].

상, 하악의 유견치, 제1, 2유구치 및 제1대구치를 구분하여 치아 종류에 따른 정확도를 평가한 결과, 상, 하악과 치아종류에 상관없이 모두 0.85 이상의 정확도로 양호한 결과를 보였다. 이 중 상악 유견치가 0.85로 가장 낮은 정확도를 보였는데, 이는 평가군에 포함된 상악 유견치의 개수가 나머지 치아보다 적어 낮은 정확도 수치가 계산되었고, 또한 상악 유견치의 파절로 인한 영역을 인접면 우식우식증으로 잘못 인식한 위양성 오류를 범한 결과이다. 추후 치아 파절에 대하여 자료군을 수집하여 추가로 학습시킨다면 이러한 부분을 개선할 수 있을 것이다.

우식증의 진행 정도에 따른 정확도 평가에서도 양호한 결과를 보였다. ADA CCS 점수가 0점일 때와 2점일 때는 각각 0.97과 0.96의 정확도를 보였고, 3점과 4점일 때는 오류 없이 완벽한 정확도를 나타내었다. 즉 정상 부위거나 상아질로 이환된 우식증 탐지에서는 뛰어난 성능을 보여주었다. 그러나 ADA CCS 점수가 1점일 때는 0.77로 상대적으로 낮은 정확도를 나타내었는 데, ADA CCS 1점인 법랑질에 국한된 인접면 우식증 영역과 치근단 방사선 사진에서 자주 나타나는 중첩현상을 모델이 완벽히는 분류하지는 못하는 것으로 생각된다.

이번 연구는 유치의 치근단 사진을 이용한 최초의 객체 탐지 연구이다. 인접면 우식증 진단에 가장 많이 사용되는 방사선 사진인 교익 방사선 사진과 치근단 방사선 사진의 차이는 촬영 각도에 따른 인접면 중첩 유무이다[8]. 인접면 중첩으로 인한 Type Ⅰ error, 즉 위양성 영역으로 인한 문제로 인해 치과의사의 진단에도 어려움이 많다. 이번 연구의 목표 중 하나는 이 위양성 영역으로 인한 문제를 개선하고자 하였다. 모델을 학습시킬 때 1차에서 나타난 위양성 영역을 다시 annotation하여 2차 학습을 시키기로 계획하였다. 그 결과 1차 학습 모델과 2차 학습 모델을 같은 학습자료군으로 성능평가 후 비교했을 때 2차 학습 모델에서 정확도, 특이도, 정밀도, F1-score에 유의미한 증가가 나타났다. 특히 특이도에서 0.58에서 0.73으로 많은 증가가 있었는데, 이는 위양성 영역의 수정으로 인한 결과로 분석할 수 있다. 2차 학습 모델로 평가자료군을 성능평가 한 결과 특이도는 0.97로, 2차 학습 모델의 학습자료군으로 성능평가 했을 때의 특이도인 0.73보다 높은 수치를 나타내었다. 하지만 이는 적은 샘플수로 인한 결과일 가능성이 높으므로, 2차 학습 모델의 학습자료군 평가 시 특이도가 평가자료군 평가의 수치보다 모델 개선에 의미가 있는 결과라 판단하고, 후속 연구에서 평가자료군의 우식증이 있는 영역 비율을 높일 필요가 있다.

2차 학습 모델의 학습자료군으로 성능평가 시의 특이도는 0.73으로, 교익방사선사진을 이용한 기존의 연구보다는 낮은 수치를 보였다[16,33,34]. 따라서 이 낮은 특이도로 인해 현재 모델은 치아우식증의 진단을 수행할 때, 치과의사의 진단 능력을 완전히 대체하기보다는 진단을 지원하는 수준으로 유용할 것이다. 그 외에도 환자 및 보호자와의 진단에 대한 설명시 우식증 진단을 보조하는 도구로써 활용한다면 치과의사의 진단 뿐만 아니라 환자에게도 시각적인 이해를 도울 수 있을 것이다. 교익방사선 사진과 치근단 방사선 사진의 간극을 줄이기 위해서는 더 많은 인접면 중첩을 가진 우식증 데이터가 필요할 것으로 생각된다. 따라서 추후 연구에서는 인접면 우식증 병소를 갖는 치근단 방사선 사진을 더 추가하여 연구를 진행한다면 위양성 오류의 개선과 함께 특이도의 향상을 도모할 수 있을 것이다.

결론

이 연구에서는 유치열기 소아의 치근단 방사선사진 2016개를 대상으로 심층학습(Deep learning) 알고리즘을 활용하여 인접면 치아우식증을 객체 탐지하는 모델을 개발 후 성능평가를 진행하였다. 평가 결과 각 평가 항목별 양호한 수치를 나타내어 좋은 성능을 보임으로써, 중첩으로 인한 왜곡이 있는 치근단 방사선사진에서도 진단 보조기능으로 전반적으로 긍정적인 결과를 얻었다. 인공지능 기술의 발전과 다양한 케이스의 방사선 사진 자료를 이용한 추가적인 학습을 통해 우식증 진단 프로그램을 계속 개선하여 성능평가시 임상적으로 사용할 수 있는 정확도까지 도달한다면, 임상적 진단 보조 도구로 활용이 가능할 것으로 기대된다.

Notes

Conflict of Interest

The authors have no potential conflicts of interest to disclose.